I modelli linguistici di grandi dimensioni (LLM) sono sistemi di intelligenza artificiale (AI) in grado di generare testo, tradurre lingue, scrivere diversi tipi di contenuti creativi e rispondere alle domande in modo informativo. Questi includono, GPT-4 di OpenAI, PaLM-2 di Google, Llama-2 di Meta, società e modelli in comprensibile competizione, visti anche i volumi di capitali investiti negli ultimi anni ed il giro di affari potenziale del settore.

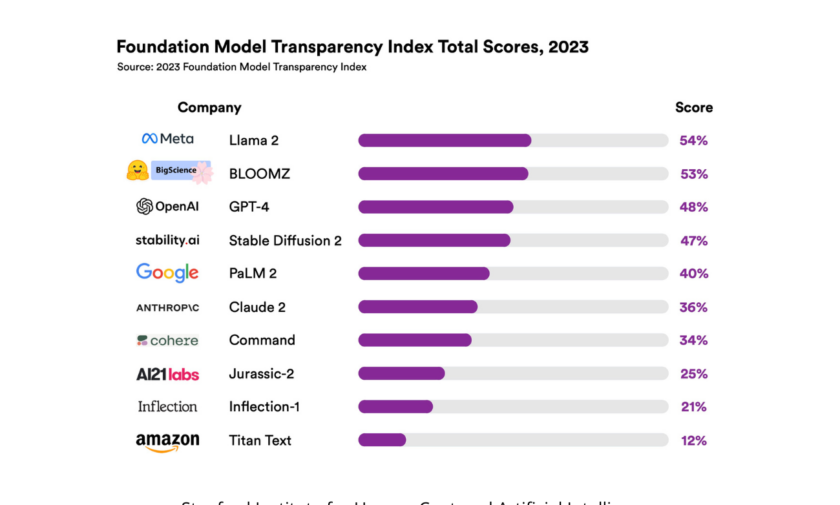

Un recente studio dell’Università di Stanford ha rilevato che i modelli linguistici di grandi dimensioni sono generalmente poco trasparenti, con un punteggio medio di 3 su 10. I ricercatori hanno utilizzato un nuovo indice di trasparenza, chiamato Foundation Model Transparency Index (FMTI), per misurare l’accessibilità e la comprensibilità delle informazioni sui modelli LLM.

“Negli ultimi tre anni è diventato chiaro che la trasparenza dei modelli di intelligenza artificiale sta diminuendo, mentre le loro capacità stanno aumentando,” ha affermato il professore di Stanford Percy Liang. “Ciò è problematico perché in altri settori, come i social media, la mancanza di trasparenza ha già avuto conseguenze indesiderate”.

Sono diversi i fattori che contribuiscono alla scarsa trasparenza dei modelli di AI, tra questi troviamo la complessità dato che gli algoritmi Deep Learning sono costituiti da milioni o miliardi di parametri, che sono i valori che determinano il modo in cui il modello funziona. La complessità di questi parametri rende difficile capire come interagiscono tra loro e come influenzano l’output del modello.

La mancanza di standardizzazione è un altro fattore che contribuisce al calcolo del punteggio FMTI. I diversi sviluppatori utilizzano differenti formati e metodologie per rappresentare le informazioni e questo rende difficile il confronto tra i diversi modelli.

Gli interessi commerciali, poi, sono un fattore che contribuisce alla riservatezza. Le aziende possono essere riluttanti a condividere informazioni, poiché potrebbero essere utilizzate da concorrenti per sviluppare modelli simili.

I ricercatori sperano che il loro rapporto possa incoraggiare le aziende ad essere più trasparenti sui propri modelli LLM di intelligenza artificiale e fornire un punto di partenza per la regolamentazione di questo settore in rapida crescita.

Le aziende in questione dovrebbero lavorare insieme allo sviluppo di standard per la trasparenza ma ciò sarà possibile solo quanto i Big Tech condivideranno le informazioni sui loro sistemi, comprese le loro architetture, i dati di addestramento e i risultati di valutazione.